Elk moment van de dag bezoeken tientallen AI-bots je website om content te verzamelen voor ChatGPT, Claude, Gemini en andere taalmodellen. Maar welke bots hebben nu precies toegang tot jouw content? En wil je dat eigenlijk wel?

Met de AI Model Index Checker krijg je in 10 seconden compleet inzicht in welke AI-crawlers toegang hebben tot je website. Geen technische kennis nodig – voer je URL in en zie direct de resultaten.

Wat is de AI Model Index Checker?

De AI Model Index Checker is een gratis online tool waarmee je in seconden kunt controleren welke AI-crawlers toegang hebben tot je website. De tool analyseert je robots.txt bestand en toont precies welke AI-systemen zoals ChatGPT, Claude, Gemini en Perplexity je content kunnen scannen voor hun taalmodellen.

Waarom is dit belangrijk?

Elk moment van de dag scannen tientallen AI-bots het internet om content te verzamelen voor het trainen van hun modellen. Zonder dat je het doorhebt, wordt jouw unieke content mogelijk gebruikt om AI-systemen zoals ChatGPT slimmer te maken – zonder dat je daar controle over hebt.

Met deze tool krijg je inzicht in:

- ✅ Welke AI-bots nu toegang hebben tot je website

- ✅ Of je robots.txt correct geconfigureerd is

- ✅ Welke crawlers je content kunnen gebruiken voor AI-training

- ✅ Of je onbedoeld AI-toegang toestaat of blokkeert

Hoe werkt de AI Model Index Checker?

Stap 1: Voer je URL in

Typ simpelweg je website URL in het invoerveld. Je kunt maximaal 100 URLs tegelijk analyseren.

Stap 2: Automatische analyse

De tool haalt automatisch je robots.txt bestand op en analyseert welke user-agents zijn toegestaan of geblokkeerd.

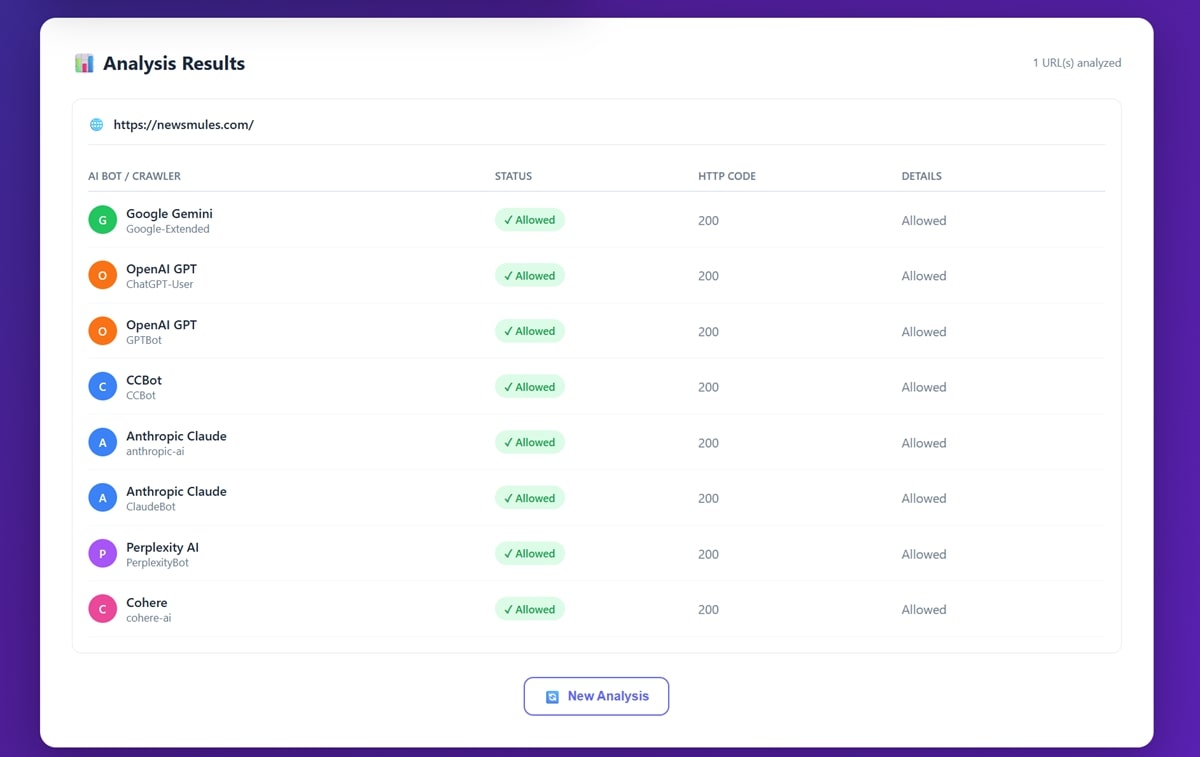

Stap 3: Duidelijk resultaat

Binnen enkele seconden zie je een overzichtelijke tabel met:

- Naam van de AI bot (bijvoorbeeld “Google Gemini” of “OpenAI GPT”)

- User-agent identifier (bijvoorbeeld “Google-Extended” of “GPTBot”)

- Status: ✓ Allowed (toegestaan) of ✕ Blocked (geblokkeerd)

- HTTP Code: Statuscode van het robots.txt bestand

Welke AI Crawlers worden gecontroleerd?

Onze tool checkt de belangrijkste AI-crawlers van 2026:

1. Google Gemini (Google-Extended)

- Google’s AI-training crawler voor Gemini en Bard

- Gescheiden van reguliere Google Search indexering

- Impact: Hoge crawl-frequentie voor diverse contenttypen

2. OpenAI GPT (GPTBot & ChatGPT-User)

- Crawlers van OpenAI voor GPT-modellen

- Gebruikt voor ChatGPT training en plugin development

- Impact: Breed websitebereik, focus op tekstuele content

3. Anthropic Claude (ClaudeBot & anthropic-ai)

- Crawlers voor Claude AI-modellen

- Bekend om respectvolle crawling met rate limiting

- Impact: Focus op hoogwaardige, gestructureerde content

4. Perplexity AI (PerplexityBot)

- Real-time search en AI-antwoord systeem

- Combineert crawling met directe antwoorden

- Impact: Recent nieuws en actuele informatie

5. Common Crawl (CCBot)

- Open-source webcrawler voor AI-datasets

- Data wordt gebruikt door talloze AI-bedrijven

- Impact: Breed bereik, publieke dataset

6. Cohere AI (cohere-ai)

- Enterprise-focused AI-platform

- B2B toepassingen en business intelligence

- Impact: Professionele en technische content

Waarom deze tool gebruiken?

Voor Website Eigenaren

Contentbescherming Veel bedrijven investeren jaren in unieke content. Met deze tool zie je of je content onbedoeld gebruikt wordt voor AI-training zonder jouw toestemming.

Competitief voordeel Als jouw content vrij toegankelijk is voor AI, kunnen concurrenten indirect profiteren van jouw kennis via AI-tools.

Bewuste keuze In plaats van bij default alles toestaan, kun je nu een geïnformeerde beslissing maken over welke AI-systemen je content mogen gebruiken.

Voor SEO Professionals

Client rapportage Toon clients precies welke AI-crawlers toegang hebben en adviseer over optimale configuratie.

Competitive analysis Analyseer hoe concurrenten omgaan met AI-crawlers en leer van hun strategie.

Technical SEO audit Robots.txt configuratie is onderdeel van moderne SEO-audits. Check of AI-blokkering per ongeluk reguliere search crawlers blokkeert.

Voor Content Creators

Intellectueel eigendom Bescherm je unieke artikelen, analyses en creative work tegen ongewenste AI-training.

Traffic behoud Als AI-systemen jouw content kunnen reproduceren, waarom zouden bezoekers nog naar je site komen?

Licentie controle Voor premium content creators: controleer of je paywall ook AI-crawlers tegenhoudt.

Praktische voorbeelden

Voorbeeld 1: E-commerce website

Situatie: Online meubelwinkel met unieke productbeschrijvingen

Check resultaten:

- GPTBot: ✓ Allowed

- ClaudeBot: ✓ Allowed

- Google-Extended: ✓ Allowed

Advies: Overweeg productbeschrijvingen te blokkeren. Concurrenten kunnen via AI vergelijkbare beschrijvingen genereren. Blog posts voor naamsbekendheid kun je open laten.

Voorbeeld 2: Juridisch adviesbureau

Situatie: Advocatenkantoor met kennisbank en case studies

Check resultaten:

- GPTBot: ✕ Blocked

- ClaudeBot: ✕ Blocked

- Google-Extended: ✓ Allowed

Advies: Goede configuratie! Gevoelige case informatie is beschermd, maar algemene juridische blog posts zijn vindbaar via Google AI.

Voorbeeld 3: Tech startup

Situatie: SaaS bedrijf met uitgebreide documentatie

Check resultaten:

- Alle bots: ✓ Allowed

Advies: Voor developer tools is openheid vaak voordelig. Documentatie toegankelijk houden vergroot developer adoption.

Veelvoorkomende bevindingen

❌ Onbedoeld alles toegestaan

Probleem: Standaard WordPress/Wix sites staan alle crawlers toe

Wat te zien:

GPTBot: ✓ Allowed

ClaudeBot: ✓ Allowed

Google-Extended: ✓ Allowed

PerplexityBot: ✓ Allowed

Oplossing: Evalueer of je dit wilt en pas robots.txt aan indien nodig

❌ Per ongeluk alles geblokkeerd

Probleem: Te strenge robots.txt blokkeert ook gewenste crawlers

Wat te zien:

Alle bots: ✕ Blocked

HTTP Code: 403

Oplossing: Check of je niet per ongeluk reguliere search crawlers blokkeert

✅ Selectieve configuratie

Ideaal scenario: Bewuste keuzes per bot-type

Wat te zien:

GPTBot: ✕ Blocked (content bescherming)

Google-Extended: ✓ Allowed (AI vindbaarheid)

ClaudeBot: ✕ Blocked (competitief voordeel)

PerplexityBot: ✓ Allowed (real-time traffic)

Hoe gebruik je de resultaten?

Stap 1: Analyseer de huidige staat

Na het runnen van de tool, noteer:

- Welke bots hebben toegang?

- Is dit wat je verwacht?

- Zijn er verrassingen?

Stap 2: Bepaal je strategie

Vraag jezelf af:

Voor content creators:

- Is mijn content mijn businessmodel?

- Wil ik naamsbekendheid of traffic behoud?

- Hoe uniek is mijn content?

Voor e-commerce:

- Zijn productbeschrijvingen mijn USP?

- Wil ik dat AI mijn producten kan “aanbevelen”?

- Wat doen concurrenten?

Voor dienstverleners:

- Is mijn expertise mijn product?

- Wil ik thought leadership via AI?

- Zijn case studies publiek of privé?

Stap 3: Implementeer wijzigingen

Als je wilt blokkeren:

Voeg toe aan je robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: ClaudeBot

Disallow: /

Als je selectief wilt zijn:

User-agent: GPTBot

Disallow: /products/

Disallow: /pricing/

Allow: /blog/

Stap 4: Monitor regelmatig

- Check elke 3 maanden met de tool

- Nieuwe AI-crawlers worden toegevoegd

- Evalueer de impact van je keuzes

Advanced features

Bulk URL analyse

Analyseer meerdere URLs tegelijk:

https://jouwsite.nl

https://jouwsite.nl/blog/

https://jouwsite.nl/products/

https://concurrent.nl

Perfect voor:

- Multi-site portfolios

- Competitive analysis

- Client audits

- Large-scale SEO projecten

HTTP Status codes

De tool toont ook HTTP codes:

200 – OK: Robots.txt gevonden en gelezen

404 – Not Found: Geen robots.txt (alles is toegestaan)

403 – Forbidden: Toegang geweigerd

500 – Server Error: Technisch probleem

Real-time resultaten

Geen cache – de tool haalt real-time je huidige robots.txt op. Wijzigingen zie je direct.

Technische details

Hoe werkt de analyse?

- Fetch robots.txt: Tool haalt je

/robots.txtbestand op via HTTPS - Parse regels: User-agent, Allow en Disallow regels worden geanalyseerd

- Match bots: Elke AI-crawler wordt gecontroleerd tegen de regels

- Resultaat: Duidelijke Allow/Block status per bot

Privacy & Security

- ✅ Geen opslag: URLs worden niet opgeslagen in onze database

- ✅ Server-side: Alle analyse gebeurt op onze server (geen data naar derde partijen)

- ✅ HTTPS: Alle communicatie is encrypted

- ✅ No tracking: We loggen alleen anonieme statistics

Beperkingen

De tool kan:

- ✅ Robots.txt analyseren

- ✅ User-agent regels interpreteren

- ✅ Allow/Disallow patterns checken

- ✅ HTTP status codes tonen

De tool kan niet:

- ❌ Garanderen dat bots zich aan regels houden (sommige negeren robots.txt)

- ❌ Server-level blocks detecteren (.htaccess, firewall)

- ❌ Meta tag configuraties lezen

- ❌ Login-walls of paywalls detecteren

Ondersteunde formats

De tool werkt met:

- ✅ Standaard robots.txt syntax

- ✅ Wildcard patterns (

*) - ✅ $ (end of URL) markers

- ✅ Case-insensitive user-agents

- ✅ Comments en lege regels

Veelgestelde vragen

Q: Is deze tool gratis?

A: Ja, 100% gratis. Geen registratie, geen limiet, geen hidden costs.

Q: Hoe accuraat zijn de resultaten?

A: Zeer accuraat voor robots.txt analyse. Let op: sommige bots negeren robots.txt, maar dat kunnen wij niet detecteren.

Q: Kan ik mijn concurrent checken?

A: Ja! Voer elk publiek domein in om te zien hoe zij omgaan met AI-crawlers.

Q: Hoe vaak moet ik checken?

A: Aanbevolen: elk kwartaal, of na robots.txt wijzigingen.

Q: Wat als ik fouten zie?

A: De tool toont wat er in je robots.txt staat. Als het niet klopt met je intentie, moet je robots.txt aangepast worden.

Q: Werkt het met elke website?

A: Ja, zolang de site publiek toegankelijk is en een geldig robots.txt heeft.

Q: Kan ik API toegang krijgen?

A: Neem contact op voor enterprise/API oplossingen.

Q: Waarom staat mijn bot er niet bij?

A: We controleren de belangrijkste AI-crawlers. Nieuwe bots worden regelmatig toegevoegd. Suggesties zijn welkom!

Best practices

✅ DO

- Test voor en na wijzigingen: Voorkom onbedoelde blokkering

- Check concurrent gedrag: Leer van hun strategie

- Documenteer je keuzes: Waarom blokkeer/sta je bepaalde bots toe?

- Review quarterly: AI-landschap verandert snel

- Test meerdere URLs: Homepage vs. subpagina’s kunnen verschillen

❌ DON’T

- Blind kopiëren: Wat werkt voor anderen werkt niet per se voor jou

- Alles blokkeren: Overweeg selectieve toegang

- Googlebot blokkeren: Check dat je niet per ongeluk Google Search blokkeert

- Negeren van resultaten: Als de tool verrassingen toont, onderzoek waarom

- Eenmalig checken: Robots.txt kan door updates veranderen

Voor developers

Integratie mogelijkheden

De tool is gebouwd met:

- Frontend: HTML, CSS, JavaScript (Vanilla)

- Backend: PHP met cURL

- API-ready: Contact us voor API endpoints

Self-hosting

Geïnteresseerd in self-hosting? De tool gebruikt:

- PHP 7.4+

- cURL extension

- Moderne browsers (ES6+)

Contributing

Open-source liefhebbers: suggesties voor nieuwe features zijn welkom via contact.

Case studies

Case 1: Medium-sized E-commerce

Voor check: Bedrijf wist niet dat alle AI-bots toegang hadden

Check resultaat: Alle bots ✓ Allowed

Actie: Productcatalogus geblokkeerd, blog open gelaten

Resultaat na 3 maanden:

- 🔒 Unieke beschrijvingen beschermd

- 📈 Blog traffic +12% (AI-vermelding in Perplexity)

- ✅ Geen impact op Google rankings

Case 2: Content Publisher

Voor check: Wilde AI blokkeren maar was onzeker over impact

Check resultaat: Alles toegestaan

Actie: Stapsgewijze blokkering: eerst GPTBot, dan monitoren

Resultaat:

- 👍 Meer controle over content

- 📊 Geen negatieve effecten op organic traffic

- 🎯 Selectieve strategie werkt

Case 3: SaaS Startup

Voor check: Per ongeluk alle bots geblokkeerd door te strenge robots.txt

Check resultaat: Alle bots ✕ Blocked, inclusief Googlebot!

Actie: Emergency fix: robots.txt gecorrigeerd

Resultaat:

- ⚠️ Crisis voorkomen (bijna uit Google verdwenen)

- ✅ Documentatie weer vindbaar

- 📈 Developer adoption hersteld

Volgende stappen

Klaar om je website te checken?

- Test je site → AI Model Index Checker Tool

- Analyseer de resultaten – Zijn er verrassingen?

- Bepaal je strategie – Blokkeren, toestaan, of selectief?

- Implementeer – Pas robots.txt aan indien nodig

- Monitor – Check elk kwartaal opnieuw

Hulp nodig?

Als SEO-specialist bij AI Linkbuilders help ik je graag met:

- 🔍 Complete SEO audit inclusief AI-crawler analyse

- 📝 Robots.txt optimalisatie voor jouw situatie

- 🎯 AI-strategie advies op maat

- 📊 Competitor analysis – wat doet de concurrentie?

Blijf up-to-date

AI-crawlers evolueren snel. Nieuwe bots worden regelmatig gelanceerd.

Wil je op de hoogte blijven?

- 📧 Schrijf je in voor mijn nieuwsbrief en blijf op de hoogte

- 🔔 Volg me op LinkedIn voor tips en tricks

- 📖 Lees mijn blog voor diepgaande guides

Tools & Resources

Gerelateerde tools:

Handige links:

De AI Model Index Checker is ontwikkeld door AI Linkbuilders – Nederlandse SEO specialisten die bedrijven helpen met moderne zoekmachine optimalisatie en AI-strategie in het tijdperk van ChatGPT, Claude, Gemini en andere AI-systemen.

Start nu met checken → AI Model Index Checker

Laatste update: Januari 2026

Tool versie: 1.0

Ondersteunde bots: 8 (GPTBot, ClaudeBot, Google-Extended, PerplexityBot, CCBot, Cohere, ChatGPT-User, anthropic-ai)